引言

本文引用地址:人工神经网络在很多领域得到了很好的应用,尤其是具有分布存储、并行处理、自学习、自组织以及非线性映射等特点的网络应用更加广泛。嵌入式便携设备也越来越多地得到应用,多数是基于ARM内核及现场可编程门阵列FPGA的嵌入式应用。某人工神经网络的FPGA处理器能够对数据进行运算处理,为了实现集数据通信、操作控制和数据处理于一体的便携式神经网络处理器,需要设计一种基于嵌入式ARM内核及现场可编程门阵列FPGA的主从结构处理系统满足要求。

1人工神经网络处理器

1.1人工神经网络模型

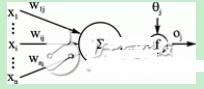

人工神经网络是基于模仿大脑功能而建立的一种信息处理系统。它实际上是由大量的、很简单的处理单元(或称神经元),通过广泛的互相连接而形成的复杂网络系统。最早的神经元模型是MP模型,由输入X、连接权值W和阈值、激活函数f和输出O组成,如图1所示。

式中:netj是神经元j的净输入,xi是神经元j的输入,wij是神经元i到神经元j的权值,j是神经元j的阈值,f()是神经元净输入和输出之间的变换函数,称为激活函数。[1]

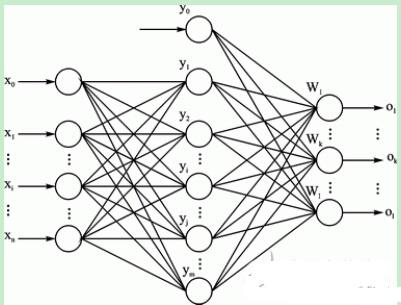

后来的各种网络模型基本都由这几个因素构成,例如图2的三层BP神经网络模型。

容易看出,各层权值调整公式均由3个因素决定,即学习率、本层输出的误差信号以及本层出入信号Y(或X)。其中,输出层误差信号与网络的期望输出与实际输出之差有关,直接反映了输出误差,而各隐层的误差信号与前面各层的误差信号都有关,是从输出层开始逐层反传过来的。

神经网络的训练学习的过程就是通过不断地调整各个节点的权值,使输出误差达到最小,最终获得稳定可靠的权值,实现网络的预定功能。

1.2人工神经网络的FPGA实现

算法公式实际隐含着各种运算过程,乘累加计算、激活函数及其导数的计算和逻辑运算是3种必不可少的运算,因此FPGA的实现主要是各种运算器的设计和连接。处理器要处理各种类型的数据,样本数据X(训练样本、实际样本),网络参数(学习速率、每层神经元个数n等)和权值W是必不可少的。网络参数和初始权值用来对网络初始化,训练样本用来训练网络学习,最后在网络应用阶段对实际样本进行处理。

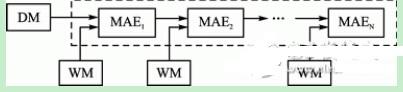

图3神经网络的运算模块和数据存储结构图

图3展示的是FPGA神经网络处理器的主体部分:存储模块和运算模块。根据网络的结构特点,连接权值处于各个神经元节点的连接处,与各自的权值运算结构一一对应,为分布式,所以分布式存储器WM中存储权值数据;样本数据统一从网络的输入层进入网络,故DM中存储样本数据;MAE是处理器的运算部分。

2通信硬件设计

2.1系统整体架构

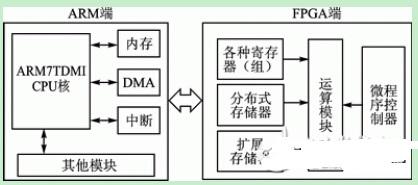

系统整体结构框图如图4所示,分为ARM端和FPGA端两个部分。ARM端有两个功能:一是从内存中读取已有数据,通过DMA方式下载到FPGA端,按照数据类型将数据下载到不同的存储设备和存储空间;二是对FPGA进行控制,主要是各种中断操作。FPGA端的功能是接收ARM传送的数据,存储数据,并在微程序控制器的控制下进行运算处理,最后把结果上传给ARM.

图4系统整体结构框图

ARM端以S3C44B0X芯片为核心,外部扩展各类设备构成。S3C44B0X是三星公司的16/32位微处理器,片内集成了ARM7TDMI核,并在此基础上集成了丰富的外围功能模块,为嵌入式设备提供一个低成本高性能的方案。

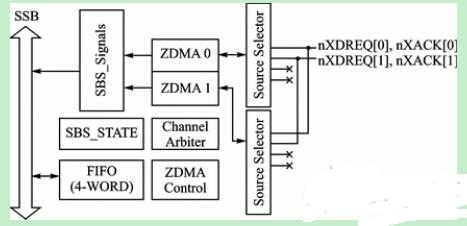

S3C44B0X拥有4通道的DMA控制器,两个ZDMA,连接于SSB(三星系统总线);另外两个BDMA,连接在SSB和SPB(三星外围总线)之间的接口层。其中ZDMA可从存储器到存储器、存储器到I/O设备和I/O设备到存储器传送数据。DMA操作由S/W或来自外部请求引脚(nXDREQ0/1)的请求来启动。[3]

在DMA操作中,通过配置DMA特殊功能寄存器来实现对DMA的控制,如图5所示。

图5 ZDMA控制器框图

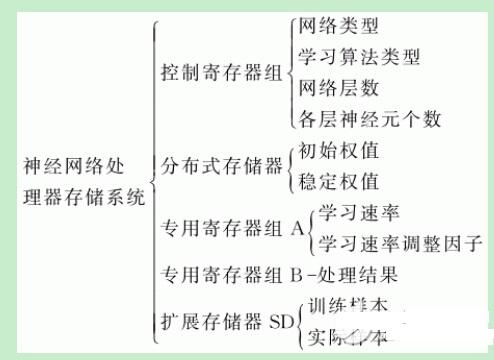

FPGA端的组成为FPGA芯片和扩展存储器。按处理数据类型的不同设计不同的存储结构,具体如下所列。神经网络的结构参数存放于控制寄存器组,初始权值、稳定权值存放于分布式存储器,其他参数(学习速率、学习速率调整因子等)存放于专用寄存器组A中,处理结果存放于专用寄存器组B中,样本数据存放于扩展存储器SD卡中。

以上所述的存储体,除扩展存储器外其他结构都在FPGA芯片内部设计完成。采用这种设计是基于FPGA片上存储资源的使用情况:①FPGA的配置文件占用;②分布式存储器占用;③各类寄存器组占用。当样本数据数量较大时会占用比较大的空间,FPGA芯片将不能满足,因此不能把样本数据存储在片上,而是存储于扩展存储器。